|

|

|

|

|

FCS | 前沿研究:人脸掩膜引导的多样化人脸图像合成 |

|

|

论文标题:Mask guided diverse face image synthesis(人脸掩膜引导的多样化人脸图像合成)

期刊:Frontiers of Computer Science

作者:Song SUN, Bo ZHAO, Muhammad MATEEN, Xin CHEN, Junhao WEN

发表时间:15 Jun 2022

DOI:10.1007/s11704-020-0400-7

微信链接:点击此处阅读微信文章

原文信息

标 题:

Mask guided diverse face image synthesis

发表年份:

2022年

原文链接:

https://journal.hep.com.cn/fcs/EN/10.1007/s11704-020-0400-7

引用格式:

Song SUN, Bo ZHAO, Muhammad MATEEN, Xin CHEN, Junhao WEN. Mask guided diverse face image synthesis. Front. Comput. Sci., 2022, 16(3): 163311

公众号推文链接:

人脸掩膜引导的多样化人脸图像合成

01导读

最近,条件生成对抗网络在根据不同类型的输入(如属性、文本描述、图像和语义分割)生成图像方面取得了显著进展。人脸图像生成作为其中一个特定的任务,在照片编辑、电影、游戏等方面具有很大的应用价值,因此引发了研究人员的广泛关注。

对于人脸图像生成任务来说,保真度是最重要的考量因素。因此,一些最近的工作如BigGAN、StyleGAN等通过设计更深的神经网络结构,改善了人脸图像生成的保真度,取得了较好的视觉效果。然而,它们本质上都属于无条件的图像生成任务,使用了随机噪声作为输入,因此在人脸图像生成过程中缺乏可控性,无法精确控制生成人脸的外观。试想如果我们可以首先通过选择脸型或眼睛的大小来指定人脸,然后再生成它,那岂不是更好?

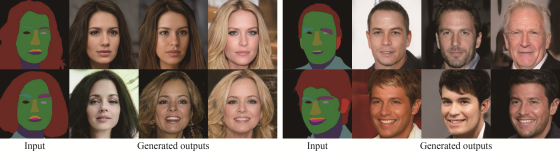

为了改善人脸图像生成的可控性,使用人脸掩膜成为了一种可能的解决方案。如图1所示,人脸掩膜为人脸图像分割后的结果。它通过指定人脸中不同部位(如眼睛、鼻子和嘴巴)的大小和位置,为人脸提供了很好的几何约束。它还定义了脸部的视角,即正面或侧面。这些信息对于一个生成模型生成逼真的人脸图像是非常有用的。

图1 掩膜引导下的多样化人脸图像合成示例

除了保真度和可控性以外,多样性是人脸图像生成中的另一个重要的考量因素。如果一个模型能基于同一个人脸掩膜生成多个不同的人脸图像,那是非常理想的。尽管目前基于掩膜引导的人脸图像生成已经有一些初步的工作,但是它们的效果仍显不足,特别是在多样性方面仍有较大的改进空间。

为了解决以上问题,本文提出了一个新颖的端到端学习框架,实现了在掩膜引导下生成多样化的、逼真的和可控的人脸图像。受StyleGAN在使用风格码(style code)调整图像生成风格的启发,本文提出了将风格码和人脸掩膜集成到生成器中。不同于以往直接将隐码(latent code)作为网络的输入,本文首先将隐码转换为编码人脸高层次风格的风格码,它提供了人脸图像的外观信息,如肤色、发型和年龄。然后,本文采用自适应实例归一化(Adaptive Instance Normalization,AdaIN)技术将风格码注入到生成器中。为了进一步地驱使模型使用风格码,本文设计了一个风格解码器从生成的图像中重建风格码。最后,本文施加了一个多样性损失函数使得模型学习去生成视觉上不同的人脸图像。

02 模型细节

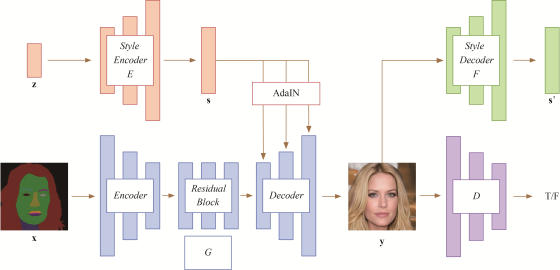

图2 本文提出的模型框架示意图

令 表示人脸掩膜域,

表示人脸掩膜域, 表示真实的人脸域。给定一个人脸掩膜

表示真实的人脸域。给定一个人脸掩膜 ,本文的目标旨在训练一个生成器

,本文的目标旨在训练一个生成器 能够生成多样化的人脸图像

能够生成多样化的人脸图像 ,如图1所示。图2展示了本文提出的模型框架,共有四部分组成,下面分别展开描述。

,如图1所示。图2展示了本文提出的模型框架,共有四部分组成,下面分别展开描述。

风格编码器(Style encoder)

给定一个随机的隐码 ,风格编码器

,风格编码器 将其编码为表示目标人脸图像的视觉风格的风格码

将其编码为表示目标人脸图像的视觉风格的风格码 。具体来说,如表A1所示,风格编码器

。具体来说,如表A1所示,风格编码器 是一个由多个全连接层组成的多层感知机(MLP),将一个隐码

是一个由多个全连接层组成的多层感知机(MLP),将一个隐码 转化为可学习的风格空间中的一个向量

转化为可学习的风格空间中的一个向量 。通过从先验的分布中采样隐码,风格编码器

。通过从先验的分布中采样隐码,风格编码器 可以生成多样化的风格码。

可以生成多样化的风格码。

生成器(Generator)

生成器 将一个输入的人脸掩膜

将一个输入的人脸掩膜 转化为一个输出的人脸图像

转化为一个输出的人脸图像 ,其中

,其中 表示风格编码器

表示风格编码器 学习到的风格码。具体来说,如表A2所示,生成器有三个子模块:编码器、残差块和解码器。编码器由若干个卷积层组成,用来编码人脸掩膜。残差块进一步地转化编码后的人脸掩膜。解码器通过堆叠若干个转置卷积层而实现。这三个子模块依次堆叠,将一个输入的人脸掩膜转化为一个输出的人脸图像。此外,在解码器中采用了自适应实例归一化(AdaIN)注入风格信息,定义如下:

学习到的风格码。具体来说,如表A2所示,生成器有三个子模块:编码器、残差块和解码器。编码器由若干个卷积层组成,用来编码人脸掩膜。残差块进一步地转化编码后的人脸掩膜。解码器通过堆叠若干个转置卷积层而实现。这三个子模块依次堆叠,将一个输入的人脸掩膜转化为一个输出的人脸图像。此外,在解码器中采用了自适应实例归一化(AdaIN)注入风格信息,定义如下:

这里使用 来缩放归一化的特征映射

来缩放归一化的特征映射 ,并将之平移

,并将之平移 。注意,这里的统计量皆是跨空间位置来计算的。

。注意,这里的统计量皆是跨空间位置来计算的。

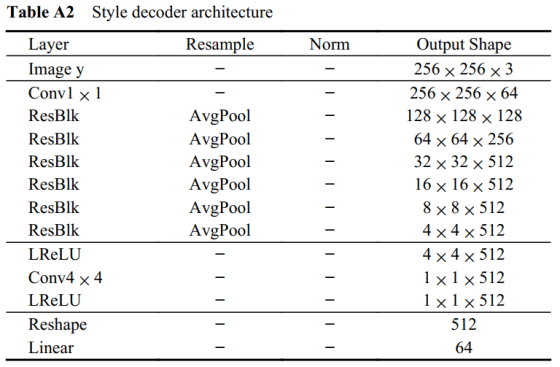

风格解码器(Style decoder)

为了迫使生成器 使用风格信息

使用风格信息 ,本文模型也设计了一个风格解码器

,本文模型也设计了一个风格解码器 ,如表A3所示,用来从生成的人脸图像

,如表A3所示,用来从生成的人脸图像 中提取风格码

中提取风格码 。因为

。因为 是从风格码中

是从风格码中 生成的,因此理想情况下,解码的风格码

生成的,因此理想情况下,解码的风格码 应该是

应该是 的重建。

的重建。

判别器(Discriminator)

如表A4所示,解码器 学习了一个二分类器,用来判定一个输入图像

学习了一个二分类器,用来判定一个输入图像 是真实图像还是由

是真实图像还是由 生成的假图像

生成的假图像 。

。

训练损失函数

本文采用对抗的方式端到端地训练风格编码器、风格解码器、生成器和判别器,所用损失函数如下:

1)对抗损失

对抗损失鼓励模型去生成逼真的人脸图像,定义为:

其中 ,为输入的人脸掩膜,

,为输入的人脸掩膜, 为采样的隐码,

为采样的隐码, 是真实的人脸图像。

是真实的人脸图像。 表示生成的人脸图像,

表示生成的人脸图像, 表示判别器的输出。风格编码器

表示判别器的输出。风格编码器 学习为生成器

学习为生成器 提供风格码

提供风格码 。

。

2)风格重建损失

风格重建损失迫使生成器 使用风格编码器

使用风格编码器 生成的风格码

生成的风格码 ,定义为:

,定义为:

其中, 将隐码转化为风格码,

将隐码转化为风格码, 用来从生成的图像

用来从生成的图像 中提取风格码。这里采用了

中提取风格码。这里采用了 范数计算转化的和提取的风格码之间的距离。

范数计算转化的和提取的风格码之间的距离。

3)多样性损失

多样性损失进一步地鼓励生成器 生成多样化的图像。为此,定义如下的损失函数:

生成多样化的图像。为此,定义如下的损失函数:

其中, 和

和 是两个随机采样的隐码,用来得到两个不同的风格码

是两个随机采样的隐码,用来得到两个不同的风格码 和

和 ,并且进一步地由

,并且进一步地由 生成两个图像。这里采用了

生成两个图像。这里采用了 范数作为图像间的距离度量。因为更多样化的图像倾向于拥有更大的距离,因此这里鼓励模型拥有更大的

范数作为图像间的距离度量。因为更多样化的图像倾向于拥有更大的距离,因此这里鼓励模型拥有更大的 多样性损失。

多样性损失。

最后,所使用的全部损失总结为:

其中, 是控制每个损失的相对重要性的超参数。

是控制每个损失的相对重要性的超参数。

测试流程

整个测试过程只保留了图2的左半部分,去除了风格解码器 和判别器

和判别器 。给定一个随机采样的隐码

。给定一个随机采样的隐码 ,风格编码器首先将其编码为一个风格码

,风格编码器首先将其编码为一个风格码 。然后,在此条件下,生成器

。然后,在此条件下,生成器 将一个输入的人脸掩膜

将一个输入的人脸掩膜 转化为一个人脸图像

转化为一个人脸图像 。

。

03 主要贡献

本文的主要创新点总结如下: (1) 提出了一个新颖的基于人脸掩膜生成逼真可控的人脸图像的框架。通过操控输入的人脸掩膜,本文的模型能够生成与之匹配的人脸图像。 (2) 通过设计风格编码器和风格解码器,并且驱使模型重建风格码,本文的模型能够从相同的人脸掩膜中生成多样化的人脸图像。 (3) 定性和定量的实验结果表明本文的模型优于其他的先进基准方法。

04 实验结果

(1)定性结果

图3定性地比较了两个基准方法pix2pixHD、CC-FPSE与本文所提模型的结果,其中第一列为输入的人脸掩膜,第二和三列分别为pix2pixHD和CC-FPSE的结果,最后三列展示了本文模型产生的多样化结果。可以看到,所有的方法都可以生成匹配输入人脸掩膜的合理人脸图像。然而,本文的模型可以生成带有更精细细节,如头发、牙齿、更少伪影的人脸图像。

图3 视觉结果比较

(2)定量结果

表1定量地比较了本文模型和基准方法在FID和LPIPS指标上的性能。可以看到,本文方法大幅超越了两个基准方法。

(3)人脸操控

图4展示了使用相同的风格码和不同的人脸掩膜生成的人脸图像。可以看到,本文的模型可以生成匹配输入人脸掩膜的人脸图像,并且同时保持身份信息。由此也表明本文模型可以通过改变人脸掩膜的不同部位或脸部的视角来操控人脸生成结果。

图4 人脸操控示例

解读:王财勇 北京建筑大学

审核: 张 琨 合肥工业大学

Frontiers of Computer Science

Frontiers of Computer Science (FCS)是由教育部主管、高等教育出版社和北京航空航天大学共同主办、SpringerNature 公司海外发行的英文学术期刊。本刊于 2007 年创刊,双月刊,全球发行。主要刊登计算机科学领域具有创新性的综述论文、研究论文等。本刊主编为周志华教授,共同主编为熊璋教授。编委会及青年 AE 团队由国内外知名学者及优秀青年学者组成。本刊被 SCI、Ei、DBLP、INSPEC、SCOPUS 和中国科学引文数据库(CSCD)核心库等收录,为 CCF 推荐期刊;两次入选“中国科技期刊国际影响力提升计划”;入选“第4届中国国际化精品科技期刊”;入选“中国科技期刊卓越行动计划项目”。

《前沿》系列英文学术期刊

由教育部主管、高等教育出版社主办的《前沿》(Frontiers)系列英文学术期刊,于2006年正式创刊,以网络版和印刷版向全球发行。系列期刊包括基础科学、生命科学、工程技术和人文社会科学四个主题,是我国覆盖学科最广泛的英文学术期刊群,其中13种被SCI收录,其他也被A&HCI、Ei、MEDLINE或相应学科国际权威检索系统收录,具有一定的国际学术影响力。系列期刊采用在线优先出版方式,保证文章以最快速度发表。

中国学术前沿期刊网

http://journal.hep.com.cn

特别声明:本文转载仅仅是出于传播信息的需要,并不意味着代表本网站观点或证实其内容的真实性;如其他媒体、网站或个人从本网站转载使用,须保留本网站注明的“来源”,并自负版权等法律责任;作者如果不希望被转载或者联系转载稿费等事宜,请与我们接洽。