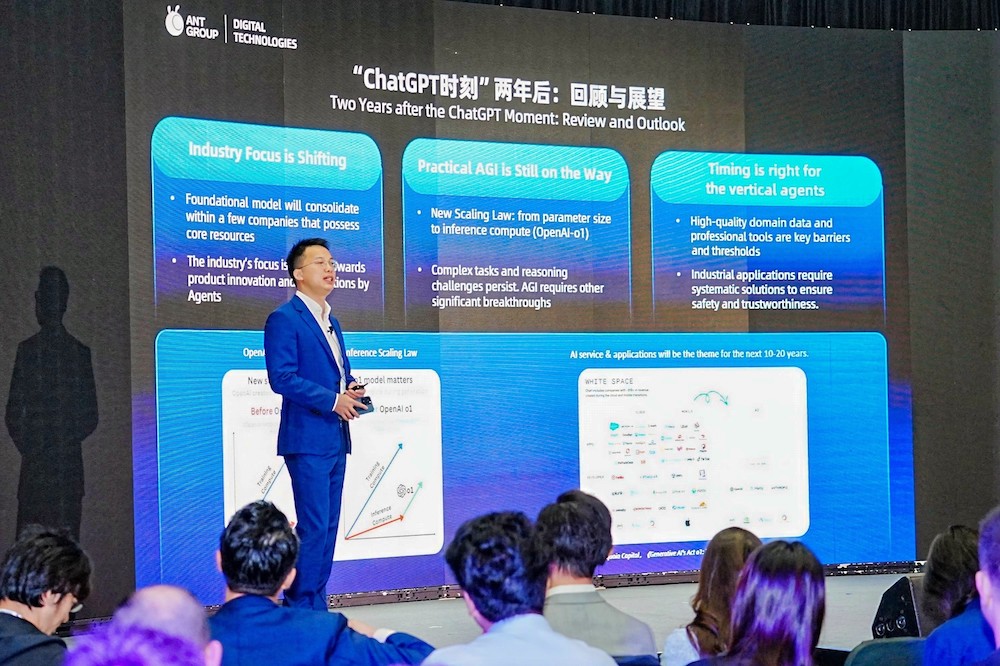

“大模型的应用从‘上新品’逐渐进入‘强应用’阶段,更好的通用人工智能(AGI)仍在路上。”10 月 29 日,蚂蚁数科CTO王维在香港金融科技周2024 上的分享中谈到大模型安全相关话题时指出,AI 是把双刃剑,生成式人工智能(AIGC)滥用风险需系统性应对。

蚂蚁数科王维在演讲活动上。蚂蚁数科 供图

蚂蚁数科王维在演讲活动上。蚂蚁数科 供图

两年前,大语言模型(LLM)的出现,引发了全球科技从业者的普遍关注和行业热潮。OpenAI推出的ChatGPT 月活用户数以史上最快速度达到 1 亿,AI 行业迎来“iPhone时刻”。经过一段时间的狂奔,LLM性能阶段性趋于饱和,大模型底层推动力逐渐收敛到少数拥有核心数据及算力资源的公司,行业注意力也更多转到了以智能体(Agent)为代表的行业应用侧。

谈及如何释放LLM 应用的局限性,王维表示,高质量行业数据和专业工具是 AI 继续发展的关键壁垒和门槛,行业应用需要系统性地解决专业严谨和安全可信等问题。蚂蚁数科为此专门开发“蚁天鉴”产品,集大模型安全测评与防御为一体,让大模型在生产和使用过程中更安全、可控、可靠。

高质量数据可以更好地模拟客观世界,提升模型的准确性和稳定性。王维称,伴随着AI发展的范式转移,对数据的要求也在持续改变,机器学习也正从“以模型为中心”转向“以数据为中心”。在当下的 LLM时代,行业应用要做到安全可信,重点是如何结合专业人工+AI算法的高效标注,产生高质量数据。

随着互联网公开数据逐步耗尽,以及GPT-o1带来的强化学习训练新范式,都预示着数据合成的重要性与日俱增。王维认为,如何通过仿真引擎、自博弈(self-play)强化学习的方式,合成出更多互联网所不覆盖的高质量、高价值领域数据,将是抵达AGI时代的关键。

不久前,2024年诺贝尔物理学奖得主、“AI 教父” 杰弗里·辛顿在采访中再次强调了其对AI安全问题的强烈担忧。他与另外两位图灵奖得主约书亚·本吉奥、姚期智及来自世界各地的几十位科学家共同签署了一封公开信——“AI 安全国际对话威尼斯共识”,呼吁为推动人工智能的发展制定更好的保障措施。

他们在公开信中警告道:“随着人工智能的快速发展,这些‘灾难性的结果’随时可能发生。”究其根源,在于 AIGC 的滥用不仅会产生虚假信息和网络钓鱼攻击,还可能引发全球性的诈骗活动。其中,值得关注的一大风险来源便是深度伪造(Deepfake), 即基于深度学习算法,从大量的视频和图像数据中学习,伪造出逼真的面部动画和语音。

王维认为,这揭示了AI 是把“双刃剑”,AIGC滥用所带来的风险需要系统性应对。他介绍说,蚂蚁数科旗下身份安全品牌ZOLOZ 为此专门研发了综合防控产品 ZOLOZ Deeper,以应对在开户、登录、支付等各种场景的深度伪造风险。在服务印尼某头部银行后,产品上线一个月时间内实现了 Deepfake 风险“0漏过”。

版权声明:凡本网注明“来源:中国科学报、科学网、科学新闻杂志”的所有作品,网站转载,请在正文上方注明来源和作者,且不得对内容作实质性改动;微信公众号、头条号等新媒体平台,转载请联系授权。邮箱:shouquan@stimes.cn。